Mucho se está hablando de la IA y, aunque tiene sus detractores y sus seguidores, en general hay una opinión común y es que necesita ser regulada. El día ha llegado. La inteligencia artificial puede ser una herramienta potentísima y excelente para el curso de la humanidad (suena irónico, ¿verdad?), pero yo también coincido en que deben establecerse unas regulaciones sobre su uso para evitar que en manos incorrectas pueda ser una bomba de relojería. Como ocurre con todo. Por eso, hoy te quiero hablar acerca de la Ley de IA europea que acaba de entrar en vigor, cuáles son sus aspectos más destacados y cómo nos puede influir.

¿Qué es la Ley de IA europea y cuáles son sus plazos?

La Ley de IA europea es el primer marco jurídico sobre IA, que tiene en cuenta sus riesgos y que coloca a Europa en una posición adelantada en esta materia respecto al resto del mundo. Esta ley está enfocada a desarrolladores e implementadores de IA, especialmente de uso profesional y, de momento, pasa por alto el uso personal que se le puede dar a estas herramientas, al menos en gran medida.

El objetivo, tal y como declara la Comisión Europea es “fomentar una IA fiable en Europa y fuera de ella, garantizando que los sistemas de IA respeten los derechos fundamentales, la seguridad y los principios éticos y abordando los riesgos de modelos de IA muy potentes e impactantes”. Además, “la Ley de IA forma parte de un paquete más amplio de medidas políticas para apoyar el desarrollo de una IA fiable, que también incluye el Paquete de Innovación en IA y el Plan Coordinado sobre IA. En conjunto, estas medidas garantizan la seguridad y los derechos fundamentales de las personas y las empresas en lo que respecta a la IA. También fortalecen la adopción, la inversión y la innovación en IA en toda la UE”.

Esta ley responde a la creación de una Oficina Europea de IA, que fue creada en febrero de 2024 dentro de la Comisión Europea y que es precisamente la encargada de supervisar el cumplimiento y la aplicación de dicha ley en los Estados miembros. Entró en vigor el 1 de agosto y los plazos que se manejan son de seis meses para que tomen efecto las prohibiciones, doce meses para que se apliquen las normas de gobernanza y obligaciones para los modelos de IA de uso general y veinticuatro meses para que sea plenamente aplicable, con una nueva excepción: las normas para los sistemas de IA integrados en productos regulados entrarán en vigor al cabo de treinta y seis meses a contar desde este 1 de agosto de 2024.

¿Cómo funcionará?

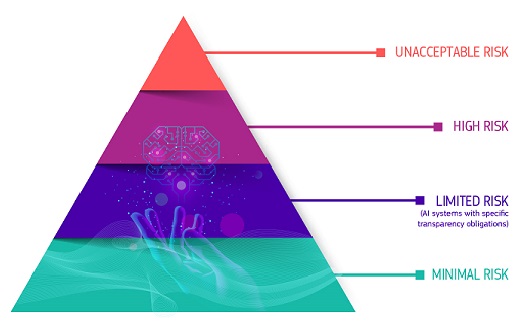

Así, este marco regulador se establece en función del riesgo que pueda ocasionar.

Tal y como explica Newtral, la IA de alto riesgo es aquella que puede tener un alto impacto en la seguridad, la salud o los derechos fundamentales de las personas. También si pueden influir de manera significativa en su toma de decisiones. Por ejemplo, aquí entrarían aquellos que afecten a la gestión de infraestructuras críticas (transportes, suministros…), los que se utilicen para contratar personas, los que se puedan utilizar en la administración de justicia, ámbito educativo, procesos democráticos o control de actividades migratorias, así como los que afecten direcamente a servicios privados o públicos esenciales.

Hay que tener también en cuenta que habrá sistemas de inteligencia artificial que queden prohibidos a partir del 1 de febrero de 2025. Estos son, por ejemplo, aquellos que evalúen a las personas en función de sus emociones o el riesgo de cometer delitos, los que utilicen la biometría para etiquetar a las personas en una base de datos en función de su raza, religión, orientación sexual, interés político, etc. Entre otros. Quedarán excluídos aquellos que se puedan utilizar por motivos de salud o seguridad.

Por otro lado, la Ley de IA europea clasifica como riesgo mínimo a aquellas que se basan en establecer filtros antispam, generación de imágenes para videojuegos, etc. Aquí, actualmente, entran la mayoría de los sistemas de IA que se están utilizando en la Unión Europea, por lo que en principio todas ellas no deberían preocuparse por esta legislación, ya que no debería suponerles un impedimento para ejercer su actividad en estos casos.

¿Cuáles serán las multas?

Este tema, si revisas la ley, también llamada AI Act, se ha quedado algo vago. No hay datos muy concretos sobre los casos a multar y cuáles serán los “castigos”. Tan solo se indica que, en base al nivel de riesgo establecido y a las herramientas que se utilicen, se puede multar a las compañías que incumplan este ley con hasta el 7% de sus ingresos mundiales.

Esto puede ser una cifra más que considerable en muchos casos, por lo que debería ser motivo más que suficiente para pensarse las cosas dos veces antes de hacerlas. Sin embargo, hay que ver finalmente cómo se aplica, ya que ese “hasta” me parece que se puede quedar en tierra de nadie y no ser del todo equitativo en todos los casos.

Además, hay que tener en cuenta también que estas herramientas tendrán que obtener un certificado, que será el que les permita operar en la Unión Europea. Todos los datos básicos están recogidos en el Pacto de la IA, un documento también de gran interés para que podamos conocer más sobre esta medida.

Hay que tener en cuenta que, de momento, estas regulaciones y multas se destinan únicamente a las compañías, no a los usuarios finales. Parece un buen punto de partida, ya que al final si no se nos dan las herramientas inoportunas no podremos hacer un mal uso de ellas. Además, el verdadero valor de este tipo de herramientas es el daño que puede ocasionar en la sociedad, más que el hecho de que una única persona pueda utilizar esta IA para su bien personal.

¿De verdad necesitamos una Ley de IA europea?

Rotundamente: sí. O al menos esa es mi opinión. Y también la de los expertos que ya están trabajando para ofrecer un marco regulador que ofrezca la protección necesaria. Protección a los usuarios, a las personas, que somos quienes realmente lo necesitamos.

Esta Ley de IA europea es un buen primer avance, pero considero que todavía no es lo suficientemente exacta y creo que en algunos aspectos (muchos) se queda algo difusa. Además, es muy complicado todavía determinar qué se ha llevado a cabo a través de IA y qué no, especialmente si afecta a decisiones.

Tenemos todavía muchos retos por delante y esto no ha hecho más que empezar. De momento, la Comisión Europea quiere poner freno a las herramientas de IA que puedan ser consideradas una verdadera amenaza para la salud, la integridad o los derechos de las personas y esto ya es una muy buena noticia.

Este enfoque basado en el nivel del riesgo no está nada mal, realmente creo que es una buena idea. Queda por ver cómo se aplica finalmente, cómo lo integran las empresas y cuáles son las primeras compañías en ser multadas por malas prácticas relacionadas con la IA.

Desde luego, tenemos por delante un panorama espectacular, tan interesante como polémico. El futuro dirá.